Projekte der Hochschulbibliothek

Aktuelle Projekte

Book Sprint: IT in BibliothekenBereich öffnenBereich schließen

Im Oktober 2023 fand an der Hochschulbibliothek der TH Wildau der dritte Book Sprint zum Thema IT in Bibliotheken statt.

Die Veranstaltung wird von Lambert Heller, Frank Seeliger und Anne Christensen organisiert. Weitere Informationen finden Sie auf dieser Webseite.

Wilma geht online als ChatbotBereich öffnenBereich schließen

Gesellschaftliche Trends der Digitalisierung und Automatisierung erfassen natürlich auch die Bibliothek und ebenfalls den Auskunftsbereich. Daraus kann neuer Service entstehen, z.B. dass man von überall mit einer Frage-Antwort-Maschine kommunizieren kann, um die Frage immer und damit online loszuwerden. Sogenannte Chatbots sind massgeschneiderte Beantworter und digitale Assistenten, welche den Wildauer Bibliotheksbetrieb gut kennen und mit diesen Informationen versuchen, Ihnen eine passende Antwort zu geben. Versuchen Sie es unter Frag Wilma

Chatbots erleben auf Grund neuer Technologien und Algorithmen auch bei Bibliotheken eine Renaissance. Wir wollen den Service systematisch ausbauen und entwickeln, geben Sie uns gerne dazu Ihr Feedback!

Idee

Die Hochschulbibliothek der TH Wildau betreibt einen Chatbot, welcher Hilfestellungen für die Anliegen und Fragen der Studierenden aufbereitet. Die aktuell existierende prototypische Implementierung dieses Chatbots wurde für eine verbesserte Erkennungsrate der formulierten Anliegen bereits von einem Statistical Language Model zu einem BERT basierten Ansatz umgestellt. Obwohl der veränderte Ansatz nachweislich Verbesserungen erwirkt, gibt es dennoch blinde Flecken, d.h. der Zusammenhang zwischen einigen elementaren Begriffen aus der Domäne der Bibliothek ist nur geringfügig (bis gar nicht) vorhanden. Beispielsweise ist der Begriff „Medien“ im vom RoboticLab Telematik verwendeten Transformer-Modell in Richtung Presse, Funk, Fernsehen ausgerichtet. Im Kontext der Bibliothek werden aber eher Bücher, E-Books, Werke, Schriften, Zeitschriften, EJournals, usw. als Medien betrachtet. Als Folge dessen führen momentan Anfragen wie „Ich suche Medien über …“ häufig zum Teilbereich „E-Books“. Das ist zwar generell nicht falsch aber die Suchanfrage definiert noch keinen bestimmten Medientypen und müsste daher über alle Medientypen suchen. Vermutlich sind die Begriffe E-Book und Medien verknüpft, weil in den Trainingsdaten häufig „Digitale Medien“ im Zusammenhang mit „E-Books“ zu sehen war.

Dieses Problem ist in der NLP-Community durchaus gängig. Fachbegriffe aus dem wissenschaftlichen Umfeld der Biologie, dem Gesundheitswesen, usw. können nicht zuverlässig verwendet werden, wodurch die Sprachmodelle qualitativ ungenügend sind. Mit BioBERT für Sprachmodelle im biologischen Kontext und SciBERT für generell wissenschaftliche Texte wurden jedoch bereits zwei BERT basierte Sprachmodelle trainiert, die sich diesem Problem annehmen. Es stellt sich nun die Frage, ob eine Fortsetzung des Transformer-Trainings mit Textdaten aus dem Umfeld von Bibliotheken gleichermaßen funktionieren kann.

Hintergrund

Ende 2018 veröffentlichte Google Forschungsergebnisse zur Erstellung von textbasierten Sprachmodellen mit Hilfe der eigens entwickelten Technik Bidirectional Encoder Representations from Transformers (BERT). Dabei handelt es sich um künstliche neuronale Netze, welche anhand der bidirektionalen Betrachtung von Millionen, Milliarden oder sogar Billiarden von Sätzen die Bedeutung von Worten im Verwendungskontext erlernt. Die Besonderheit hierbei ist nicht die Erstellung eines Sprachmodells als solches oder die Verwendung von Machine Learning Ansätzen. Beides gibt es bereits in Form von Statistical Language Models und Neural Language Models. Die Innovation ist die bidirektionale Betrachtung, d.h. der Satz wird von links-nach-rechts und rechts-nach-links gleichermaßen analysiert. Zusätzlich wurde mit BERT das sogenannte Masked Language Modeling (MLM) eingeführt. Hierbei werden zufällig Worte aus einem Satz entfernt und das Modell muss während des Trainings vorhersagen, welches Wort am besten in den aktuellen Satzkontext passt. Mit der Next Sentence Prediction (NSP) wurde ein weiterer Baustein für ein verbessertes Sprachmodell-Training eingeführt. Mittlerweile gilt NSP jedoch als wenig hilfreich und wird daher in Weiterentwicklungen vernachlässigt. Im Kern bestehen Transformer Sprachmodelle aus einem tiefen neuronalen Netz, welche durch ein bzw. zwei Trainingsphasen für gewünschte Einsatzzwecke vorbereitet werden. Im ersten Schritt erfolgt ein allgemeines Training (Pre-Training) zur Erlernung von Wortbedeutungen und kontextuellen Beziehungen zwischen Worten. Daraus resultieren hochdimensionale Vektorräume mit denen mathematische Rechenoperationen durchführbar sind. Zusätzlich erfolgt das zweite Training, in welchem die zuvor erlernten Informationen – in Form der Vektorräume – auf ein bestimmtes Lernziel (Fine-Tuning) angewendet werden. Bekannte Lernziele sind die Herausfilterung von Textabschnitten basierend auf Fragen (Question Answering), die Zuordnung von Texten zu Themenbereichen (Document Classification) oder auch die Erkennung von emotionalen Empfindungen in Texten (Sentiment Analysis).

Google selbst verwendet seit Dezember 2019 ein eigens trainiertes BERT Modell für eine optimierte Auswahl von Suchergebnissen. Das Unternehmen nennt die Einführung von BERT einen Meilenstein für Suchmaschinen und spricht von der ersten echten kontextsensitiven Suche im Internet. NLP-Content-Matching/knowledge based question answering. Die Verwaltung von Wissen nimmt eine wichtige Rolle in Organisationen ein. Wissensdatenbanken ermöglichen dabei unabhängig von Zeit, Raum und Personen an Informationen zu gelangen und eine einheitliche Informationsqualität sicherzustellen. Als Ressourcen fungieren dabei größtenteils im Umlauf befindliche Textdokumente, von Ideenpapieren bis hin zu Benutzerhandbüchern. Etwa 80% aller Daten sind unstrukturiert, also ohne Angabe was sie repräsentieren – dazu zählt insbesondere Text.[1]

Die Pflege einer Wissensdatenbank ist meist ermüdend und zeitaufwändig. Insbesondere, wenn die einzupflegenden Daten unstrukturiert sind und somit zumindest einer rudimentären Strukturierung für Suchalgorithmen bedürfen. Daher werden die Dokumente standardmäßig mit Tags aus Schlüsselworten markiert, um eine Keyword-Suche zu ermöglichen. Erweiternd existiert die Volltextsuche, welche Übereinstimmungen zwischen Eingabe-String und Text-String(s) für die Ergebnisausgabe verwendet.[2] Beide Verfahren sind etabliert, aber statisch. Sie basieren auf bloßen String-Vergleichen, die es bereits seit Jahrzehnten gibt. Häufig gibt es entweder gar kein Ergebnis (weil keine Strings übereinstimmen) oder es gibt viel zu viele mögliche Ergebnisse (weil zu viele Strings übereinstimmen).

Direkte String-Abgleiche, egal ob bei Keywords oder im Volltext, haben ein generelles Problem: Sprache ist nicht eindeutig. Die Suchergebnisse ignorieren inhaltsmäßige Ähnlichkeiten: Verwenden Benutzer nicht das „Firmenvokabular“, sondern Synonyme oder thematisch ähnliche Begriffe, so gibt es kein passendes Suchergebnis. Auch lässt sich nicht garantieren, dass eine direkte String-Übereinstimmung auch das beste Ergebnis liefert. Es fehlt die semantische Komponente, die es erlaubt, eine Gesamteinordnung zwischen Suchanfrage und Texten der Wissensdatenbank vorzunehmen.

Transformer-Sprachmodelle ermöglichen semantische QA-Systeme durch das Aufspüren von kontextuell ähnlichen Textinhalten und sind daher ideal. Auch Google verwendet seit dem Jahreswechsel 2019/2020 einen BERT-Transformer für ein verbessertes Verständnis der natürlichsprachlich formulierten Sucheingaben – laut Google die größte Erweiterung des Suchalgorithmus seit Jahren und ein enorm wichtiger Faktor für die Zukunft von Suchmaschinen.[3] Eine Integration dieses Ansatzes in textbasierte Suchsysteme, ist daher sehr vielversprechend. Bei einer Wissensdatenbank müssen dazu notwendige „contextualized embeddings“ für jeden enthaltenen Text erzeugt und gespeichert werden. Diese lassen sich entweder Wort für Wort, Satz für Satz oder auch über den ganzen Text mit eingehenden Fragen verwenden. Somit können nicht nur Übereinstimmungen von Keywords, sondern ganze Sätze und Textabschnitte auf semantische Ähnlichkeit geprüft werden. Außerdem lassen sich die Ergebnistreffer nach Relevanz sortieren, da das Transformer-Sprachmodell mathematische Operationen zwischen Frage und Antwort(en) erlaubt und damit die „Nähe“ zueinander berechnet.

Dialogsystem

Auch wenn rudimentär bereits seit vielen Jahren im Bereich des E-Commerce vorhanden, feierten Sprachdialogsysteme (auch bekannt als Sprachassistenten, Chatbots) erst im Jahr 2017 ihren wirklichen Durchbruch. Ihr Einsatzbereich hat sich dabei stark erweitert und lässt sich neben E-Commerce nun auch im Endbenutzermarkt (z.B. Smartspeaker in der Wohnung, Chatbot im Smartphone) vorfinden.[4]

Aktuelle Dialogsysteme (z.B. Amazon Alexa, Rasa, IBM Watson Assistant) fokussieren sich auf die Erkennung von Bedürfnissen direkt aus dem verbalen Kommunikationsanteil. Formulierte Aussagen werden wortwörtlich durch das Dialogsystem analysiert. Dabei erfolgt ein Abgleich der Aussage des menschlichen Kommunikationsteilnehmers mit einer Liste von möglichen Themenbereichen (intents) und erwarteten Beispielformulierungen (training data), die im Chatsystem hinterlegt sind. Außerdem können Gesprächsverläufe durch fest programmierte Pfade simuliert werden (dialog stories).[5]

[1] Christie Schneider; The biggest data challenges that you might not even know you have

; www.ibm.com/blogs/watson/2016/05/biggest-data-challenges-might-not-even-know/

Als Beleg dient an dieser Stelle Zendesk (Cloudbasierte Kundensupport Software Plattform mit über 40.000 Kunden): support.zendesk.com/hc/de/articles/211317328-Übersicht-über-die-Endbenutzersuche-im-Help-Center

[3] Pandu Nayak; Understanding searches better than ever before

; www.blog.google/products/search/search-language-understanding-bert/

[4] Frank Bentley et al.; Understanding the Long-Term Use of Smart Speaker Assistants

; dl.acm.org/doi/abs/10.1145/3264901

Als Beleg dient die Softwaredokumentation von Rasa: rasa.com/docs/rasa/

Humanoider Roboter WilmaBereich öffnenBereich schließen

Seit September 2016 verfügt die Hochschulbibliothek über eine 1.20 große Kollegin mit dem Namen Wilma, welche vom französisch-japanischen Hersteller (Aldebaran/SoftBank) als Pepper ausgeliefert wird. Der gleichzeitig angeschaffte zweite Pepper der Hochschule mit dem Namen Bernd befindet sich im RoboticLab des Studiengangs Telematik.

Der humanoide Roboter soll im Rahmen einer hochschulinternen Zielvereinbarung unter dem Titel „Pepper4Library“ zusammen mit dem Team um Frau Prof. Mohnke für den Bibliothekseinsatz bis 2018 vorbereitet werden. Erstreckt sich sein "Können" auf tablet-gesteuertes Fahren und Bewegen, Spiele wie Schere-Stein-Papier, Witze erzählen, eine Bibliotheksführung, wird gerade intensiv an der Ortung und Navigation gearbeitet, an einem Tutorial zur Erläuterung der Drucker-Scanner-Kopiermaschine etc. Als fahrende und interaktive Litfaßsäule soll Wilma sich über alle drei Etagen mittels des Fahrstuhls bewegen können, die natürliche Sprache verstehen und kommunizieren können, gezielt Hinweise vermitteln, um in den Nachtzeiten und an den Wochenenden Bibliotheksbenutzern Hilfestellung zu geben. Damit kann die unbemannte Bibliothek, welche über ein chipkartenbasiertes Zugangssystem verfügt, auch außerhalb der üblichen Servicezeiten einen Grundbedarf an Serviceleistungen anbieten, wie man es im online-Zeitalter und der Ära von RFID-Selbstverbuchern auch sonst gewohnt ist.

Digitales Bildarchiv für die TH WildauBereich öffnenBereich schließen

Seit 2021 arbeitet die Hochschulbibliothek am Aufbau eines digitalen Bildarchivs für die TH Wildau,

welches den gesamten Bildbestand der Hochschule in Kollaboration mit den entsprechenden Sachgebieten systematisch erschließen und den Hochschulangehörigen digital zur Verfügung stellen soll.

Weitere Informationen zum Projekt finden Sie auf unserer Projekt-Seite.

Abgeschlossene Projekte

Systematikumstellung auf RVKBereich öffnenBereich schließen

Seit Januar 2017 stellte die Hochschulbibliothek bei laufendem Betrieb ihre Systematik von der der Gesamthochschulbibliotheken des Landes Nordrhein-Westfalen (GHB), die seit 2004 nicht mehr fortgeführt wird, auf die der Regensburger Verbundklassifikation (RVK) um. Die RVK-Systematik ist geeignet für wissenschaftliche Bibliotheken und Institutionen jeder Größe, für Freihand- und Magazinbestände, und dient zugleich als gemeinsames Sacherschließungsinstrument. Die RVK besteht aus 33 Fachsystematiken, die dem klassischen Fächerkanon der deutschen Universitäten entsprechen. Das Expertenwissen seitens der Bibliotheken und seitens der Wissenschaft bildet aktuelle Entwicklungen im wissenschaftlichen Diskurs in der Klassifikation ab.

Visualisierung der AbschlussarbeitenBereich öffnenBereich schließen

abschlussarbeiten.th-wildau.de

Im Zuge der 30-jährigen Geschichte der TH Wildau wird seit Jahr und Tag von den AbsolventInnen jeweils ein Belegexemplar ihrer Abschlussarbeit (Diplom, Bachelor, Master, Technik- Ingenieurarbeit, Dissertation) in den Bibliotheksbestand integriert. Sie ist eine Pflichtabgabe und somit eine lückenlose Dokumentation der für die Graduierung bearbeiteten Themen. Damit stellt die Kollektion der Abschlussarbeiten das Bleibende, gewissermaßen das Vermächtnis der AbsolventInnen dar. Das Bibliotheksteam ist sich der besonderen Verantwortung hinsichtlich der Konservierung sehr bewusst. Sie möchte nun einen Schritt aus dem üblichen Bestandsnachweis heraus wagen und die Darstellung dieses Schatzes für alle Interessenten erfahrbarer gestalten. Die quantitative Darstellung in statistisch interaktiven Schaubildern soll einen neuen Zugang bieten.

Die Abschlussarbeiten genießen den Status eines Archivbestandes im Sinne der dauerhaften Datenvorhaltung (keine Kassierung) und Einzigartigkeit (Unikat). Die Bibliothek erfüllt mit dieser Aufgabe die Funktion einer Gedächtnisinstitution.

Die Sammlung der Abschlussarbeiten umfasst über 14.000 Werke und ist in den Nachweissystemen der Bibliothek (Online-Katalog webOPAC und Suchmaschine WILBERT) mit den üblichen bibliographischen Daten erfasst und darüber hinaus inhaltlich erschlossen. Die Notwendigkeit dazu ergab sich aus der sehr intensiven Nutzung des nur vor Ort einsehbaren Bestandsegments. D.h. die Arbeiten sind mit kontrolliertem Vokabular verschlagwortet (gemäß der sog. Gemeinsamen Normdatei - GND) und mit ihren dazugehörigen Inhaltsverzeichnissen als maschinenlesbare Informationen erfasst. Bis 2022 werden alle Abschlussarbeiten seit Gründung der TH Wildau auf diese Weise erschlossen sein. Diese Informationen zum Bestandssegment der Wildauer Abschlussarbeiten sind über Facettierungseinstellungen im suchmaschinenbasierten Discovery-Tool Wilbert recherchier- und darstellbar.

Die vorliegenden Daten zu den Abschlussarbeiten und die zugrunde liegende offene Infrastruktur sind der Ausgangspunkt, um die Menge an Daten zu analysieren und anzuzeigen. Mit diesem Feature soll für das Jubiläum und darüber hinaus eine webbasierte Lösung angeboten werden, auf einer virtuellen Zeitschiene Entwicklungen, Tendenzen und Schwerpunkte der Abschlussarbeiten qualitativ und quantitativ attraktiv darzustellen. Hierzu werden sachbezogene Felder wie Titeldaten, Schlagworte, Publikationsjahr, Sprache, Studiengang, Graduierung und Inhaltsverzeichnisse analysiert. Auf der Zeitachse sich ergebende inhaltliche Cluster in der Ergebnisanzeige können über die Verlinkung in die exakte Darstellung einer Discovery-Anzeige (Wilbert) überführt werden. Man kann sich damit bis auf einzelne Abschlussarbeiten aus der Visualisierung hineinzoomen. Ein interaktives Erlebnis im Datenbestand 30-jähriger Historie von Abschlussarbeiten wird auf der Web-Plattform möglich, siehe abschlussarbeiten.th-wildau.de.

Jugend trainiert für GeschichteBereich öffnenBereich schließen

Wildau und die umliegenden Orte sind voller Geschichte und Geschichten: Warum gibt es kein Freibad mehr in Wildau, weshalb sagt meine Tante immer Poliklinik zum Gesundheitszentrum und was bedeuten die verfallenen Bunkereingänge an der Westhangtreppe?

Zu solchen und ähnlichen Fragen rund um Wildau wollen wir uns kontinuierlich treffen und arbeiten, teils auf dem Hochschulcampus der TH Wildau in der MKAW und in der Ludwig Witthöft Oberschule – ein Projekt und Versuch zugleich. Bis Februar 2020 sollen kurzweilige Podcasts zur Lokalgeschichte Wildaus von Jugendlichen für Jugendliche und Erwachsene produziert werden. Das Ziel der wöchentlichen Zusammenkünfte liegt darin, noch unentdeckte Schätze zu heben! Begleitet wird das Projekt durch den Schulsozialarbeiter, Mitarbeiter der Musik-und Kulturakademie Wildau und der TH Wildau.

Ein Projekt in Zusammenarbeit mit der Bibliothek der TH Wildau und der Musikakademie Wildau gefördert durch den Bibliotheksverband e.V. aus Mitteln des Bundesministeriums Kultur macht Stark.

Mehr Informationen zu "Jugend trainiert für Geschichte"

KompetenzclusterBereich öffnenBereich schließen

Angehörige der Hochschule haben hier die Möglichkeit, ihre Fach- und Interessensgebiete zu definieren. Anhand dieser Informationen organisiert die Bibliothek den Medienerwerb passend zu ihrer Beschreibung. Zur Anmeldung

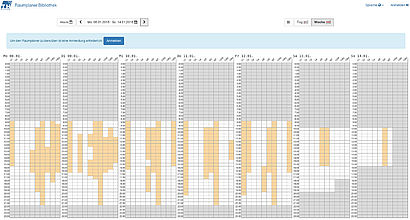

RaumplanerBereich öffnenBereich schließen

Seit Sommer 2017 ist ein Online-Raumvergabesystem in der Hochschulbibliothek im Einsatz. Studierende und Angehörige der TH Wildau haben hiermit die Möglichkeit, selbstständig Räume, die von der Bibliothek verwaltet werden, zu reservieren. Eine Reservierung kann über die Campus-App Unidos

oder über raumplaner.bib.th-wildau.de getätigt werden. Bisher war die Raumvergabe nur per Mail- oder Telefonanfrage möglich.

Technisch umgesetzt mit AngularJS und NodeJS. Der Quellcode steht auf Anfrage zur Verfügung.

Bewerbungen für BibliothekspreiseBereich öffnenBereich schließen

In den vergangenen Jahren hat sich die Hochschulbibliothek um verschiedene Bibliothekspreise beworben. Die Bewerbungen wurden als kleine Projekte dokumentiert und stehen hier zur Verfügung.

- 2019: Bewerbung zur Bibliothek des Jahres vom Deutschen Bibliotheksverband (dbv)

- 2018: Bewerbung zur Bibliothek des Jahres vom Deutschen Bibliotheksverband (dbv)

- 2017: Bewerbung zur Bibliothek des Jahres vom Deutschen Bibliotheksverband (dbv)

- 2016: Bewerbung zur Bibliothek des Jahres vom Deutschen Bibliotheksverband (dbv)

- 2014: Redefining the information landscape für den Stanford Prize for Innovation in Research Libraries (SPIRL)

BibliotheksinformatikBereich öffnenBereich schließen

Seit Oktober 2015 wird am Wildau Institute of Technology e.V. an der Technischen Hochschule Wildau (Graduate School der TH Wildau) berufsbegleitend und gebührenpflichtig der Masterstudiengang Bibliotheksinformatik über vier Semester angeboten werden. Anvisiert ist die - salopp formuliert - IT-Besohlung von gestandenen Bibliothekaren, die sie befähigen soll, Herausforderungen und Veränderungen im technischen Informationsumfeld proaktiv mit zu gestalten, die Fähigkeit Programmcode zu produzieren, ist damit mit inbegriffen.

RFIDBereich öffnenBereich schließen

In der Hochschulbibliothek ist seit dem Umzug in Halle 10 in 2007 RFID für die Selbstverbuchung und Mediensicherung im Einsatz. Seitdem werden an der TH kontinuierlich Ideen und Prototypen rund um das Thema RFID im Bibliotheksumfeld entwickelt. Beispielhafte Projekte:

RFID-Rückstelltische

Seit Ende 2014 sind 11 unserer Rückstelltische mit RFID ausgestattet. Diese dienen der Erfassung von Medien, die im Haus genutzt werden und geben den Mitarbeitern der Bibliothek Ausfschluss über die Nutzungsfrequenz von Lesesaalbeständen. In unseren Nachweissystemen (Wilbert und OPAC) wird der aktuelle Standort der Medien im Wegweiser live dargestellt.

RFID-Inventur

Seit 2012 wird in der Hochschulbibliothek jährlich eine Komplettaufnahme über die Monografie-, Lesesaal, und Lehrbuchbestände per RFID durchgeführt. In den ersten beiden Jahren noch mit einer Kombination aus stationärerem Lesegerät und Notebook durchgeführt, wurde die Bearbeitung durch den Einsatz einer neuen kabellosen Antenne wesentlich verbessert. Als Grundlage der Inventurarbeiten dient eine Webanwendung, die dem Ausführenden alle wesentlichen Informationen auf dem Bildschirm des mitgeführten Notebooks darstellt.

ThesaurusBereich öffnenBereich schließen

Seit 2013 wurde an der Hochschulbibliothek der TH Wildau mit EFRE-Förderung ein zweisprachiger Thesaurus (dt./en.) für die Fachgebiete Informatik, Wirtschaft und Verkehr aufgebaut. Ziel war es, den Studierenden einen Überblick über ihr Studienfach und angrenzende Fachbereiche zu bieten. Darüberhinaus wurde der Thesaurus als Recherchehilfe in der Bibliothekssuchmaschine Wilbert integriert.

Visualisierung von BuchcovernBereich öffnenBereich schließen

Auf der Basis von three.js werden in der Minirealisierung Bücherhelix die Cover der sogenannten "digitalen Schätze" der Bibliothek visualisiert. Der Anwendung zu Grunde liegt die Darstellung und Animation des Periodensystems der Elemente, jedoch ist die Abwandlung mit der Nutzung von Buchcovern ungleich weniger attraktiv.